L’IA pourrait devenir le catalyseur d’un changement fondamental dans l’industrie technologique. Et selon Arm, la clé de cet avenir réside dans l’inférence, non dans l’entraînement – et principalement à la périphérie.

« Ce n’est pas une année ordinaire », déclare Chris Bergey, SVP et GM de la division Client Line of Business chez Arm, lors de son allocution d’ouverture au Computex à Taïwan. « Nous sommes à l’aube du moment le plus important de l’histoire de la technologie. » À ses yeux, l’IA n’est plus un simple mot à la mode, mais une réalité qui redessine tous les secteurs. « Aujourd’hui, chaque décision de produit est une décision liée à l’IA. Chaque équipe est devenue une équipe d’IA. »

Ce qui le fascine particulièrement, c’est la rapidité avec laquelle l’IA évolue. Plus de 150 nouveaux modèles de base ont été lancés au cours des 18 derniers mois, chacun avec des précisions supérieures à 90 pour cent. « Nous sommes passés de simples invites à des interactions multimodales, et même à des applications d’IA physiques. La progression est vertigineuse, » affirme M. Bergey.

Du cloud vers la périphérie : l’inférence comme clé de l’échelle

Néanmoins, il affirme que la véritable valeur commerciale de l’IA ne réside pas dans l’entraînement de ces modèles – aussi impressionnant soit-il – mais dans l’inférence, et plus spécifiquement : l’inférence à la périphérie. « L’entraînement nécessite une puissance de calcul immense, mais c’est l’inférence qui détermine si l’on crée de la valeur. Celle-ci doit être rapide, économe en énergie et disponible partout. »

L’entraînement nécessite une puissance de calcul immense, mais c’est l’inférence qui détermine si l’on crée de la valeur.

Chris Bergey, SVP et GM de Client Line of Business chez Arm

Selon M. Bergey, la latence est LA raison pour laquelle l’inférence se déplace vers la périphérie. « Les assistants IA qui réagissent en temps réel ne peuvent pas se permettre d’aller constamment dans le cloud. » De plus, l’efficacité des coûts joue un rôle de plus en plus important. « L’inférence en périphérie rend l’IA accessible pour des applications au niveau du consommateur, sans dépendre de la capacité des centres de données. »

À titre d’exemple, il fait référence aux lunettes alimentées par l’IA de Ray-Ban en collaboration avec Meta, qui se vendent très bien en Europe. « Ce qui semblait être de la science-fiction il y a six mois est aujourd’hui un produit de détail. »

L’IA nécessite une nouvelle infrastructure

Le virage vers la périphérie a de grandes implications pour l’infrastructure. Dans une séance de questions-réponses séparée avec la presse, M. Bergey souligne que les architectures héritées comme x86 n’ont pas été conçues en tenant compte de l’IA. « Elles ont été construites pour des serveurs web, pas pour des charges de travail nécessitant des ExaFLOPS. » Selon Arm, l’ère de l’expansion par l’ajout de racks est révolue. « Nous devons faire plus avec moins de watts par FLOP. »

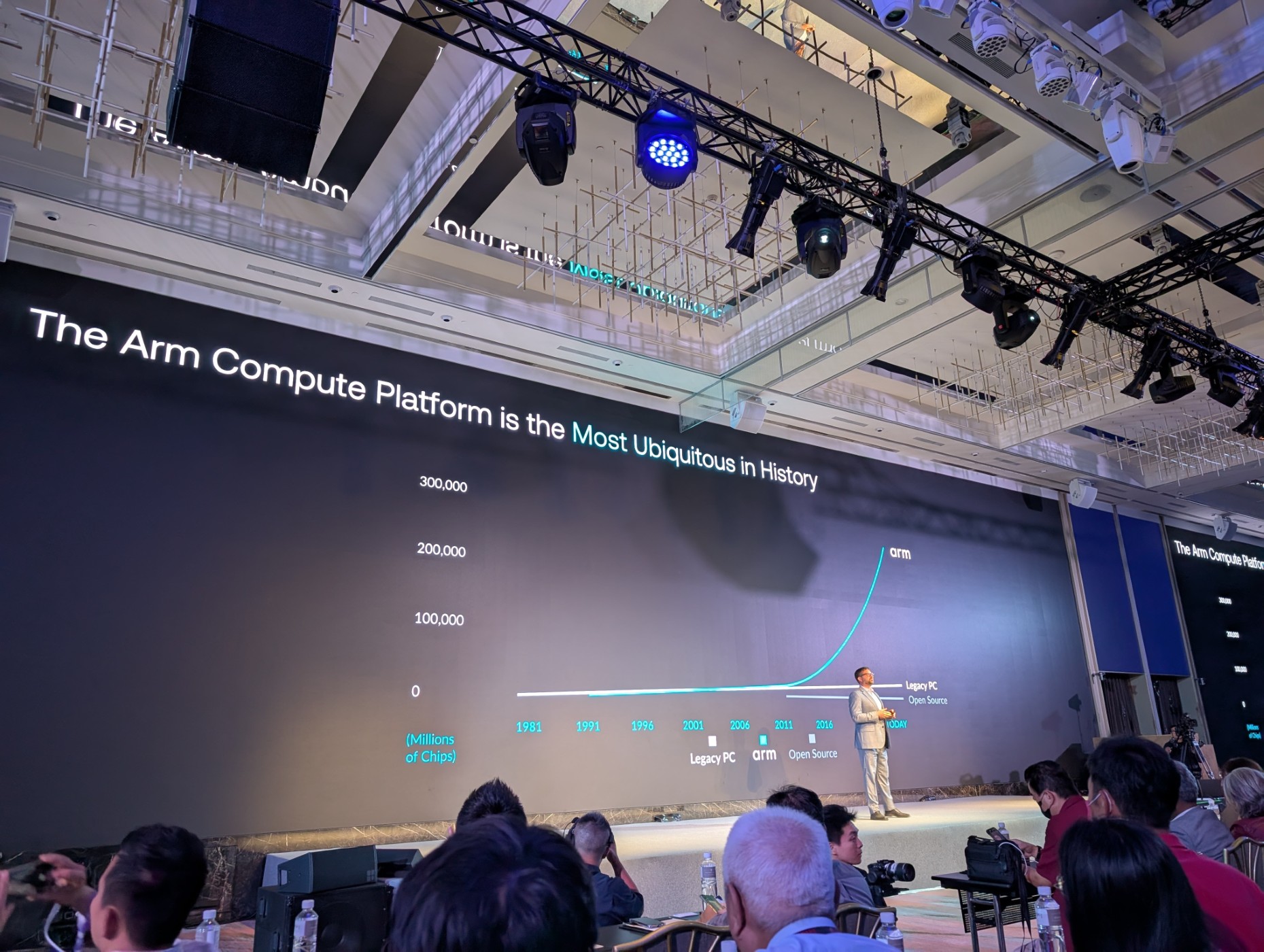

M. Bergey mentionne que les hyperscalers en sont conscients. Selon les chiffres d’Arm, plus de 50 pour cent de la capacité CPU récemment ajoutée par AWS serait basée sur l’architecture Arm via ses propres puces Graviton. Microsoft, Google, Oracle et Alibaba investissent également massivement dans les puces Arm pour leurs propres charges de travail IA et celles de tiers.

Une plateforme, pas un fabricant de puces

Un élément frappant lors de la séance de questions-réponses avec la presse était le positionnement clair de M. Bergey concernant Arm au sein de l’écosystème IA. Bien qu’Arm fournisse de la propriété intellectuelle à, entre autres, Nvidia (DGX Spark, Grace Blackwell), il souligne que l’entreprise ne souhaite pas devenir un fabricant de puces. « Notre rôle est de soutenir l’écosystème, pas d’entrer en concurrence avec lui. »

Arm maintient son modèle ‘partenaires d’abord’. L’entreprise fournit de la propriété intellectuelle et des outils de développement utilisés par des partenaires tels que MediaTek, AWS et Qualcomm pour construire leurs propres solutions. « Nous veillons à ce que les développeurs puissent construire sur une base cohérente, évolutive et économe en énergie, des wearables aux supercalculateurs IA, » déclare M. Bergey.

Concernant la rumeur selon laquelle Arm travaillerait sur ses propres puces pour concurrencer les hyperscalers, le silence est maintenu pendant le Computex. L’entreprise aurait apparemment déjà convaincu Meta d’adopter la puce. Étant donné l’expertise d’Arm et les ambitions de Meta, le composant propriétaire concerne probablement un CPU pour serveurs.

Kleidi : accélérer à l’échelle

L’un des atouts d’Arm dans ce domaine est Kleidi, une couche d’accélération IA annoncée l’année dernière au Computex. Selon M. Bergey, elle a déjà été installée huit milliards de fois en un an. Kleidi est intégré dans des frameworks tels que ONNX (Microsoft), LiteRT (Google), ExecuTorch (Meta) et Angel (Tencent), et veille à ce que les charges de travail IA fonctionnent immédiatement de manière optimale sur le matériel basé sur Arm.

« Kleidi montre ce qui est possible lorsque l’on intègre intelligemment l’accélération IA dans la pile logicielle. Et cela prouve que nous ne sommes pas seulement une entreprise de matériel, mais une véritable plateforme, » déclare M. Bergey.

Maintenant que les hyperscalers trouvent leur chemin vers Kleide, il est fort probable que tout s’accélérera pour Arm.

L’infrastructure d’IA doit être repensée

Bergey met également en garde contre un piège : « Nous pouvons parler de la promesse de l’IA, mais sans une infrastructure écoénergétique, l’IA ne sera jamais déployée à grande échelle. » Il souligne que les GPU restent essentiels, mais que les CPU deviennent un goulot d’étranglement s’ils ne peuvent pas suivre le flux de données vers les GPU.

La solution ? De nouveaux systèmes équilibrés dans lesquels CPU, GPU et éventuellement NPU collaborent plus étroitement. « Ce que Nvidia a fait avec Grace Blackwell montre cette direction. Mais on voit aussi apparaître la co-conception de silicium personnalisé chez d’autres hyperscalers. »

Il va sans dire que Bergey voit Arm au cœur de tous ces concepts. Moins il y a de x86, mieux c’est pour eux.

Enfin : momentum et maturité

Chris Bergey conclut par un message clair : l’IA est partout – mais Arm veut s’assurer que l’IA puisse fonctionner partout : dans les appareils en périphérie, dans le cloud, dans les wearables, dans les centres de données. « Nous ne sommes plus en train de poursuivre un effet de mode. Nous construisons la fondation sur laquelle cette nouvelle vague d’intelligence peut fonctionner. »

L’IA a changé les règles du jeu. Et Arm a contribué à concevoir le plateau.

Chris Bergey, SVP et GM de Client Line of Business chez Arm

Avec l’IA comme force motrice et l’inférence comme base pour générer des revenus, Arm se profile comme le moteur silencieux de la révolution de l’IA. Non pas avec des démos tape-à-l’œil, mais avec une technologie évolutive et écoénergétique qui permet aux autres d’innover.

Ou comme le dit Bergey : « L’IA a changé les règles du jeu. Et Arm a contribué à concevoir le plateau. »