Un jour, les serveurs multi-socket avec plusieurs CPU sur une seule carte mère étaient la norme pour les systèmes puissants. Leur utilité semble aujourd’hui s’être affaiblie. L’avenir est-il aux serveurs à socket unique ?

Le serveur double socket ne tient qu’à un fil. AMD l’a poussé à bout, mais les systèmes multi-socket sont en mauvaise santé depuis longtemps. Quel est le pronostic et comment en est-on arrivé là ?

Partager les moyens

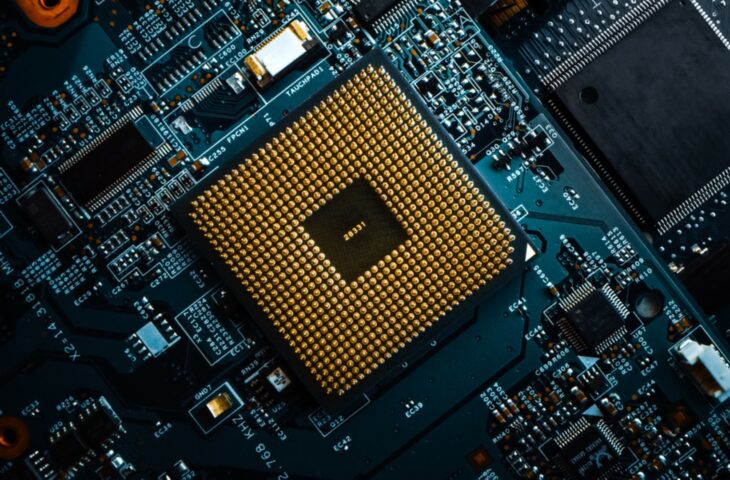

Les systèmes multi-socket sont depuis longtemps la norme pour les serveurs d’entreprise. Un système multi-socket comporte généralement deux, mais parfois aussi quatre processeurs sur une carte mère. Les serveurs combinent la puissance de traitement de plusieurs processeurs avec d’autres ressources système partagées telles que la mémoire et les accélérateurs. Initialement, un processeur était une puce dotée d’un seul cœur de calcul. En faisant travailler ensemble deux à quatre cœurs sur une seule carte mère, un serveur pouvait plus facilement effectuer des tâches avancées.

Les serveurs combinent la puissance de calcul de plusieurs CPU avec d’autres ressources système partagées telles que la mémoire et les accélérateurs.

L’amélioration des performances n’est pas le seul facteur qui a incité à combiner plusieurs processeurs sur une seule carte mère. Il y avait également une motivation économique. La capacité des différents composants de la carte mère, tels que le Northbridge (contrôleur de mémoire) et le Southbridge (contrôleur I/O) qui facilitaient les connexions à la RAM, au PCIe et au stockage, était supérieure à ce que nécessitait un seul CPU. Il en va de même pour les autres composants du serveur, comme le bloc d’alimentation (PSU). Avec une puissance relativement faible par processeur, un seul PSU pouvait alimenter plusieurs processeurs sans trop d’effort. Une configuration avec plusieurs CPUs a exploité au maximum tous ces composants.

D’une approche efficace à un nouveau goulot d’étranglement

Cependant, la technologie des processeurs a évolué. L’indispensable Northbridge n’est plus un composant séparé du chipset, mais est intégré au CPU. Les processeurs eux-mêmes sont également devenus plus rapides et ont été dotés de plusieurs cœurs de calcul. Alors qu’à l’époque, la présence de plusieurs processeurs sur une même carte mère permettait de réaliser des économies d’échelle, les limites des composants et des connecteurs sur la carte mère sont aujourd’hui dépassées. Le CPU n’est plus le goulot d’étranglement.

Intel a toutefois maintenu les systèmes multi-socket pendant longtemps en limitant le nombre maximal de cœurs de calcul sur ses puces Xeon. Tant qu’une puce individuelle restait en dessous d’un certain niveau de performance, il était toujours intéressant de pousser plusieurs CPU dans un système multi-socket.

Les fabricants de cartes mères et de serveurs, comme Intel lui-même, pourraient en outre demander une prime importante. De plus, il faut acheter deux processeurs de pointe. Comme Intel était le monopoliste, il n’y avait pas de pression du côté des fournisseurs pour faire évoluer la situation.

AMD bouleverse le marché

Cela a changé avec le retour de l’AMD. Le fabricant, dépassé par Intel au début des années 2000, n’a pas joué un rôle pertinent dans le paysage des serveurs pendant longtemps. En 2017, il y a eu un retour en force sous le nom d’AMD Epyc. Ce concurrent d’Intel Xeon reposait sur une toute nouvelle architecture, était fabriqué dans les usines de puces les plus avancées de TSMC et donnait à Intel une avance considérable en termes de rapport qualité-prix.

Avec son architecture Zen, AMD a opté pour un plan de construction établi sur des puces CPU relativement faciles à combiner, reliées par leur propre interconnexion. Grâce à cette approche, AMD a pu produire des processeurs avec un nombre énorme de cœurs de calcul.

Aujourd’hui, une seule puce AMD Epyc comporte jusqu’à 64 cœurs de calcul, soit 128 « threads ». Malgré ce nombre considérable de cœurs de calcul, la puce peut atteindre une vitesse d’horloge maximale de 3,675 GHz.

Assez de nœuds

En comparaison, lors du lancement d’Epyc en 2017, AMD est sorti avec une puce à 32 cœurs, tandis qu’Intel Xeon Scalable a culminé à 28 cœurs. Ce fut en soi un grand saut pour Intel. Les années précédentes, les modèles supérieurs de la série Intel Xeon E7 ne comptaient que 15 à 18 cœurs. Entre-temps, Intel a été obligé de hausser la barre. La troisième génération de Xeon Scalable culmine à 40 cœurs, mais le processeur Intel Xeon Platinum 9282 d’une génération antérieure en compte exceptionnellement 56.

En même temps, AMD prévoit de nouvelles puces avec 96 et même 128 cœurs. Autrement dit, vous obtiendrez bientôt autant de puissance de calcul avec une puce Epyc d’AMD que sept puces Xeon E7 en 2016. Pour alimenter 128 puissants cœurs de calcul, il faut une machine solide dotée d’une mémoire ultra rapide. Les autres composants forment un obstacle. Alors pourquoi combiner plusieurs unités centrales dans un même serveur ?

Le marché est en évolution

Ce n’est pas nouveau. Tout en haut du spectre informatique, les nœuds de serveurs les plus puissants au monde sont des systèmes de calcul haute performance (HPC). Les superordinateurs Frontier et El Capitan, en projet, franchiront pour la première fois aux États-Unis la barre de l’exaflops en termes de puissance de calcul. Les puces d’AMD Epyc sont utilisées pour la fabrication. Un nœud de serveur contient quatre GPU couplés à une seule puce AMD dans une configuration single socket.

Les géants du cloud, qui s’efforcent toujours d’optimiser leur infrastructure, suivent la même voie. D’un côté, il y a AWS, qui s’appuie de plus en plus sur ses propres puces Graviton fondées sur ARM comme CPU. Ces processeurs fonctionnent à nouveau dans des configurations single socket. D’autre part, les instances AMD single socket gagnent en importance comme alternative aux équivalents Intel. L’avantage considérable en termes de prix séduit de nombreux clients.

Le bureau d’études de marché IDC constate que cette tendance se manifeste dans le domaine des serveurs en général. « L’évolution de la technologie des serveurs a permis de produire des serveurs single socket de niveau entreprise », disent-ils. « Ils améliorent la flexibilité et l’efficacité du centre de données. En adoptant des serveurs single socket pour certaines charges de travail, les clients informatiques peuvent réaliser des économies qui étaient impossibles dans les architectures à double socket. »

De la norme à la marge

Le serveur double socket ne disparaît pas pour toujours. En fonction de la charge de travail, une architecture comportant deux petites puces au lieu d’une grande présente parfois des avantages. En général, cependant, les jours de gloire de la puce multi-socket semblent être terminés. La tendance des processeurs dotés d’un nombre astronomique de cœurs ne pousse pas à un renouvellement. AMD est trop heureux de profiter de la position dominante du single socket. Pour l’instant, il continue à travailler sur des puces plus puissantes qui réduisent les configurations multi-socket à un produit de niche.

En général, les jours de gloire de la puce multi-socket semblent être terminés.

Au total, la fin de l’ère de la configuration multi-socket comme norme pour les serveurs axés sur les performances est donc proche. De plus en plus de cœurs sont disponibles à des prix de plus en plus compétitifs pour un nombre croissant d’organisations. Par ailleurs, à l’extrémité supérieure du spectre, les spécialistes du HPC et du cloud optent également pour des solutions single socket. Pour sa part, Intel doit suivre la stratégie d’AMD ou risquer d’être exclu du marché. Par conséquent, le serveur à double socket n’est pas mort, mais il est moins pertinent que jamais.