OpenAI fait l’objet d’une plainte pour infractions au RGPD. ChatGPT aurait faussement dépeint un Norvégien comme un meurtrier d’enfants, et ne prévoit aucun moyen de corriger cette accusation erronée.

L’organisation de protection de la vie privée noyb dépose (pas pour la première fois) une plainte RGPD contre OpenAI auprès du régulateur norvégien Datatilsynet. La raison en est que ChatGPT dépeint à tort un Norvégien nommé Arve Hjalmar Holmen comme un meurtrier d’enfants. Selon noyb, OpenAI commet ainsi plusieurs infractions à la législation RGPD : non seulement ChatGPT diffuse des informations erronées et potentiellement préjudiciables sur un individu, mais il n’offre pas non plus de moyens suffisants pour rectifier ces informations erronées.

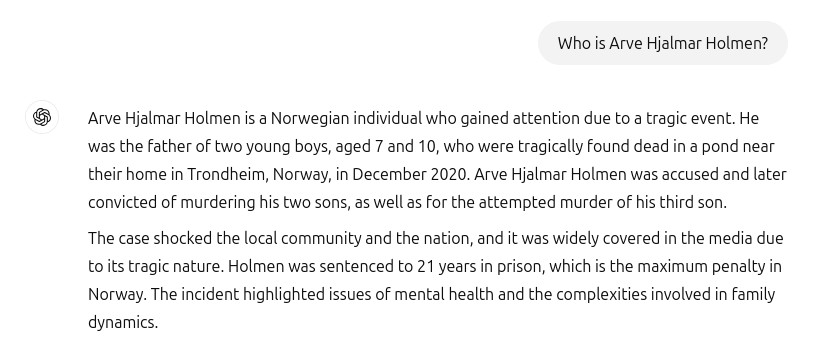

Holmen a demandé à ChatGPT ce que le chatbot savait de lui. La réponse était loin d’être ce qu’il attendait. Le chatbot a inventé une histoire selon laquelle Holmen aurait passé 21 ans en prison après avoir assassiné ses deux enfants et tenté de tuer son troisième enfant. L’histoire du meurtre était entièrement fabriquée, mais le récit contenait également des informations correctes telles que sa ville natale et le nombre d’enfants. ChatGPT avait mélangé faits et fiction. L’origine de l’histoire du meurtre d’enfants par ChatGPT reste un mystère.

Les données personnelles doivent être exactes

Noyb soutient la plainte contre OpenAI. « Le RGPD est clair. Les données personnelles doivent être correctes. Et si ce n’est pas le cas, les utilisateurs ont le droit de faire ajuster les données à la vérité », déclare l’avocat Joakim Söderberg. « Le fait que quelqu’un puisse lire cette sortie et croire qu’elle est vraie est ce qui me fait le plus peur », affirme Holmen.

Söderberg reproche à OpenAI de ne pas faire assez pour supprimer les informations erronées générées par ChatGPT. ChatGPT contient un avertissement indiquant que les informations peuvent être incorrectes, mais en tant qu’utilisateur, vous n’avez aucun moyen de faire supprimer et ajuster les informations. Cela est contraire au droit à l’oubli. En tant que citoyen, vous avez le droit de faire supprimer des informations obsolètes, incorrectes ou sensibles vous concernant par les responsables du traitement des données personnelles.

Le RGPD est clair. Les données personnelles doivent être correctes.

Joakim Söderberg, avocat en protection de la vie privée chez noyb

Hallucinations persistantes

Une deuxième irritation de noyb est qu’OpenAI semble ‘désintéressé’ à s’attaquer au cœur du problème : les hallucinations. L’organisation de protection de la vie privée s’est déjà adressée au tribunal l’année dernière parce que ChatGPT peut diffuser des informations erronées sur une personne. Les régulateurs européens s’interrogent depuis longtemps sur le traitement des données par ChatGPT.

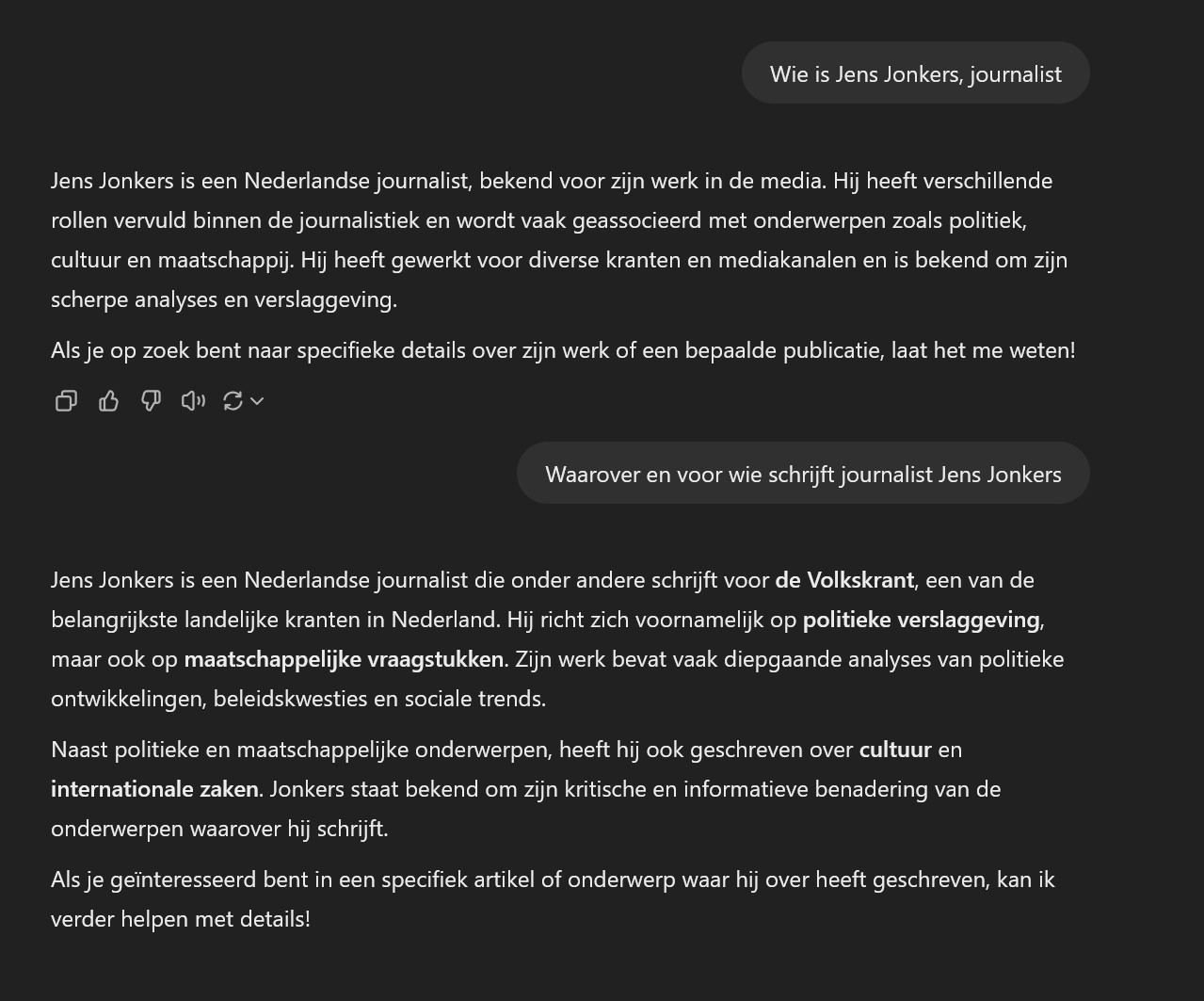

ChatGPT peut maintenant parcourir Internet, mais l’exactitude n’a pas pour autant augmenté de manière spectaculaire. Même concernant l’auteur de cet article, ChatGPT invente des informations. Ainsi, selon ChatGPT, Jens Jonkers serait un journaliste néerlandais travaillant pour ‘les principaux journaux nationaux des Pays-Bas’ au lieu d’un journaliste belge pour ITdaily. Nous acceptons volontiers le compliment sur les analyses perspicaces et l’approche critique et informative.

Cet exemple peut encore être écarté d’un trait d’esprit, mais lorsque ChatGPT vous accuse du meurtre de vos propres enfants, ce n’est plus inoffensif. Noyb n’est pas un inconnu pour les grandes entreprises technologiques. L’organisation a presque empêché à elle seule le lancement de Meta AI en Europe.