Le premier algorithme pouvant apprendre des choses de manière autonome aurait été conçu. Il semblerait que cet honneur soit réservé à Meta.

Des chercheurs de Meta affirment avoir mis au point un algorithme capable de se former à partir de plusieurs sources d’information. L’algorithme peut utiliser du texte, des images et des fragments de discours comme matériel d’apprentissage. Cela ouvrirait la voie à une IA plus avancée, capable d’accomplir de multiples tâches différentes.

Combinaison non réalisable auparavant

Selon les chercheurs, l’algorithme mis au point est unique, car il peut utiliser tous les éléments de l’environnement pour s’entraîner. Auparavant, il était impossible d’utiliser à la fois du texte, du son et des images pour un algorithme et il fallait faire un choix. Selon les chercheurs, grâce au nouvel algorithme data2vec, les possibilités sont plus diverses.

En outre, pour data2vec, il était toujours nécessaire de fournir un grand nombre de données d’entrée étiquetées. Cela peut être des fragments de texte ou de son étiquetés, avec lesquels l’algorithme a appris à se concentrer sur certaines choses. Après ce processus d’apprentissage, l’algorithme peut prédire des mots pour des fragments de texte ou des sons pour des fragments de son.

Data2vec

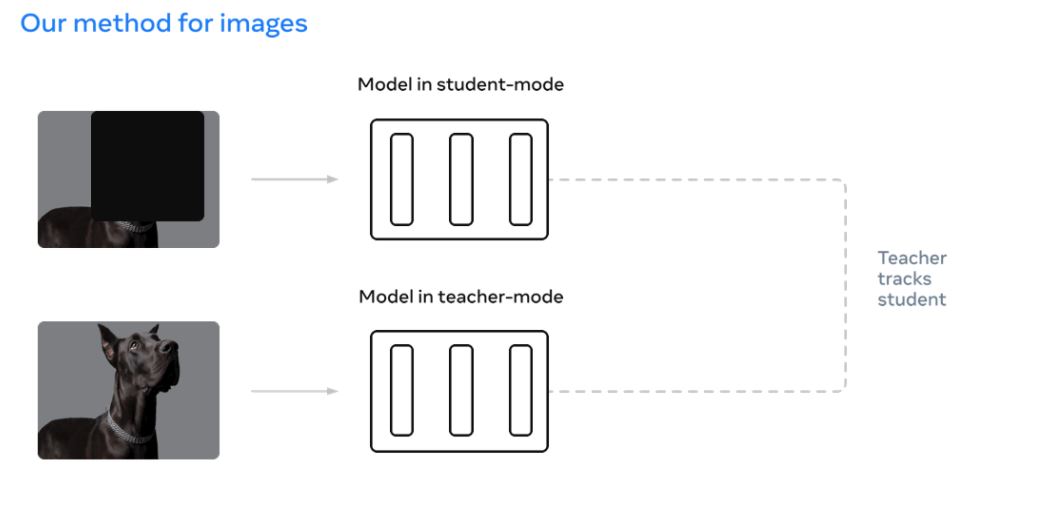

À data2vec, les chercheurs de Meta ont mis au point une nouvelle méthode. Au lieu de laisser le modèle d’IA se concentrer sur les mots, les sons ou les images, l’algorithme permet aux modèles d’IA de prédire leurs propres représentations des données d’entrée. Les personnes estiment également leur environnement en combinant différents stimuli. Par exemple, nous ne percevons une scène de nuit dans un film comme palpitante que si la musique nous le fait comprendre.

Mark Zuckerberg, fondateur de Meta, exprime son enthousiasme pour data2vec sur Facebook : « La recherche en intelligence artificielle de Meta a construit un système qui apprend à partir de la parole, de la vue et du texte sans avoir besoin de données d’entraînement étiquetées. » Selon lui, l’algorithme pourrait parfaitement être intégré aux casques de RA à l’avenir afin de contrôler l’assistant IA.

Les chercheurs de Meta partagent maintenant le code et plusieurs modèles déjà formés avec d’autres chercheurs dans le domaine. De cette façon, data2vec peut servir de point de départ et être perfectionné par les chercheurs.